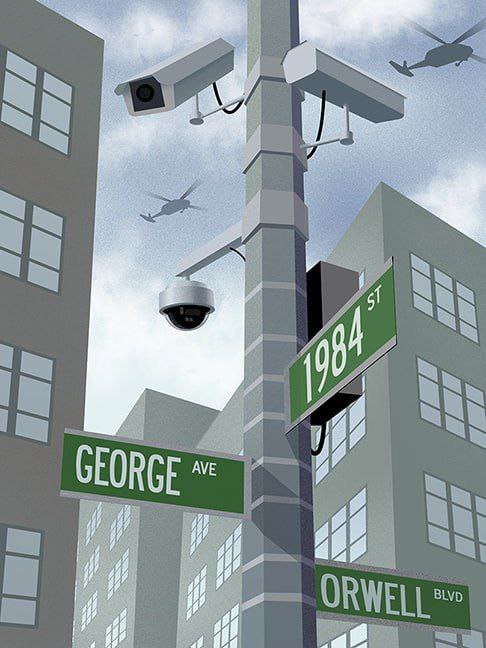

Les Jeux olympiques et paralympiques de 2024 organisés en France sont le prétexte idéal pour l’installation massive de caméras fonctionnant avec l’intelligence artificielle qui est tout sauf intelligente.

Cette intelligence artificielle a pour mission de repérer les « comportements anormaux » de la population. Le 30 aout dernier, le décret d’application de la loi relative aux Jeux olympiques et paralympiques de 2024 énumère ce que sont ces « comportements anormaux » que doit détecter l’intelligence artificielle à l’aide de milliers de nouvelles caméras. Et la liste est tout simplement stupéfiante. Ainsi, on apprend que les badauds marchant à contre-sens susciteront immédiatement une alerte adressée par l’intelligence artificielle aux services de sécurité. De même, « une densité trop importante de personnes » est de nature à inquiéter l’intelligence artificielle. Mais le décret ne donne aucune indication de nombre à partir duquel cette densité de personnes serait considérée trop importante. Noémie Levain, juriste active au sein de l’association Quadrature du Net, rappelle que « pendant le Covid, on parlait de rassemblement pour six personnes regroupées ». Les déplacements en famille ou entre amis vont devenir compliqués.

Caméras dites intelligentes

La confiance de l’Etat et des grandes entreprises dans des caméras de surveillance fonctionnant avec intelligence artificielle devrait inquiéter tous les gens de bon sens. Certains collectivités locales ont mis en place des caméras de surveillance dont l’intelligence artificielle estime que rester immobile plus de 300 secondes est un comportement suspect. Il va devenir dangereux d’attendre trop longtemps en rue une personne avec laquelle on a rendez-vous !

Savez-vous qu’en 2015, la SNCF a expérimenté une surveillance vidéo qui prétendait détecter les individus suspects en analysant leur température corporelle. Prendre un train en étant fiévreux ferait de chacun de nous un suspect de terrorisme ? Quant à la société Datakalab, elle prétend détecter les émotions de « personnes consentantes ». En 2021, cette société avait travaillé avec la RATP et Accor Arena de Bercy pour repérer les voyageurs sans masque.

Prédictions erronées de l’intelligence artificielle

Rappelons aussi que la société Veesion – qui a pour clients 3 000 entreprises françaises dont de nombreuses enseignes de la grande distribution – fonctionne avec un logiciel de « reconnaissance prédictive » destiné à réduire les risques de vols. Mais de plus en plus de cas sont signalés de personnes arrêtées par un agent de sécurité pour un « geste suspect » signalé par le logiciel en question alors que, après vérification, ces personnes n’avaient rien volé.

Cette société où les caméras dites intelligentes sont surtout omniprésentes fait de chacun de nous un suspect de tous les instants.

Pierre-Alain Depauw

Cet article vous a plu ? MPI est une association à but non lucratif qui offre un service de réinformation gratuit et qui ne subsiste que par la générosité de ses lecteurs. Merci de votre soutien !

C’est fou ce qu’ils sont indisciplinés ces pays de l’UE à l’Est!

La Slovaquie n’accepte pas de musulmans, faute de mosquées; la Bulgarie surveille ses frontières avec des chars…

Et nous on laisse faire, sans réagir, pour favoriser le remplacement…

Deux poids deux mesures, en Europe?

Je comprends les bulgares ils ont était envahit par les turcs pendant 800 ans!Ils ont pas envie d’être envahit!